애플 CSAM 검열: 원리와 근황, 중단한 이유

얼마전 카카오톡 검열 광풍이 한번 휘몰아쳤죠. 카톡 검열은 찻잔속의 태풍일뿐, 전세계 대략적으로 10억명 정도 아이폰 유저의 폰을 들여다볼 CSAM 관련글들을 보니 미래는 우리가 홀로 숨쉴곳이 없을 수 있겠구나.. 하는 생각이 듭니다.

작년부터 말이 나왔었는데 점점 구체화되어가고 있는 소식이 들려오다가 내려놨다는 말도 들렸다가.. 그만큼 비판과 저항도 큽니다.

저와 이 글을 보시는 분은 왜 CSAM 걱정을 하는 걸까요? 우리의 폰안에 나쁜 사진이나 동영상이 있는 범죄자거나 그럴 계획이 있어서? 아닙니다. 이 기술에 대해 불쾌감을 느끼거나 우려의 목소리를 내는 것이 전세계적인 것을 보면 우리가 이상한 것은 아닌것 같습니다. 그 누구도 사생활 침해를 좋아할 사람은 없으니까요.

목차

검열 자체가 기분나쁘다.

저는 맥북을 구매하고나서 앱도 상당히 많이 구매하고 즐겁게 사용하고 있습니다. 제 블로그 메뉴를 보시면 mac app 리스트를 보실 수 있는데, 돈 많이 쓴만큼 잘 쓰고 있습니다.

하지만 저는 아이클라우드에 나와 가족들의 사진을 저장하진 않을 것 같습니다. 명분은 어린이 보호라고 내세우고 있지만 그 뒤로 어떤 목적이 있는지 알 수 없고, 사적인 영역에 마음대로 접근할 수 있다는 것 자체가 솔직히 소름끼치기 때문입니다.

어쩔 수 없는 흐름이라 생각하고 저는 개인용 NAS에 자료를 관리하고 개인정보와 관련없는 자료들은 가성비 좋은 클라우드 공간에 올리거나 사진 2차 백업은 비밀번호로 압축해서 6개월~1년단위로 올리고 있습니다.

아이폰 CSAM 긍정적인 부분은?

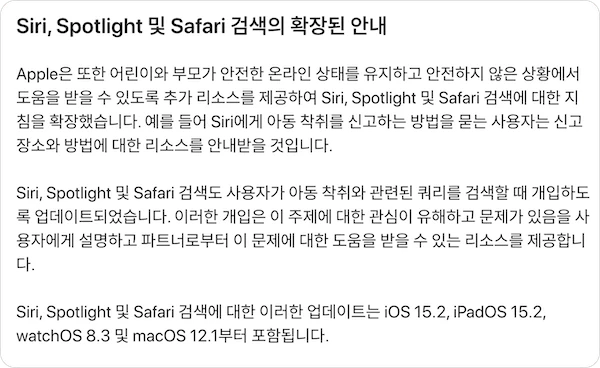

2021년 11월 9일 iOS 15.2 두번째 베타에 ‘어린이를 위한 Messages Communication Safety 기능’이 추가 되었습니다.(#macrumors)

이 기능은 저도 찬성입니다. 이는 부모가 설정해두면 어린이가 누군가로 부터 보내선 안될 사진을 받거나 혹은 보내려고 하면 이미지는 블러 처리된 뒤 사진을 받거나 보내지 않아도 된다는 경고 메세지와 함께 누군가에게 요청할 수 있도록 한다고 합니다.

이렇게 부모의 승인아래 어린 아이들을 보호할 수 있는 기능은 매우 반가운 소식입니다.

딱 여기까지는 좋습니다. 하지만 다 큰 어른의 폰에서 무슨 일이 일어나는지 애플이 아무리 잘나도 자기 손바닥 보듯 하는 것은 말이 안됩니다.

CSAM 시스템 작동 원리

CSAM의 원리가 궁금해서 찾아봤습니다. 우선 iCloud 계정에 올라가있는 사진과 미 당국에서 제공하는 데이터베이스의 해쉬값과 매칭시키는 모양 입니다.

애플이 NCMEC(National Center for Missing and Apected Children *미 국립실종 및 착취아동센터)에 관련 정보를 제공할 수 있도록 알려진 CSAM 이미지 해시의 데이터베이스와 일치하는 이미지의 임계값 수를 초과하는 계정에 플래그를 지정합니다. 이 프로세스는 안전하고 사용자의 개인 정보를 보호하도록 특별히 설계되었습니다.

CSAM Detection Technical Summary August 2021

쉽게 비교하면 COPS나 이번 카톡 검열 시스템이랑 모두 기본적 원리는 같습니다. 데이터베이스의 값과 매칭시켜서 문제가 되는 것을 찾겠다는거죠.

iSpy가 될까?

애플측에서도 ‘감시’, ‘감청’, ‘빅브라더’ 이런 이미지는 최대한 피하고싶은지 사람들이 반발할 부분에 대해서는 미리 ‘개.인.정.보.안.전.하.다’고 아래와 같이 공지했습니다.(2021년 9월 발표 내용)

- Apple은 CSAM 데이터베이스와 일치하지 않는 이미지에 대해서는 아무것도 학습하지 않음.

- iCloud Photos 계정에 대해 일치 임계값이 초과될 때까지 일치하는 CSAM 이미지의 메타데이터 또는 시각적 파생물에 액세스할 수 없음.(조건이 되면 액세스 가능이란거야 뭐야;)

- CSAM 시스템이 사용자 계정에 플래그를 잘못 지정할 위험(생사람 잡을 확률)은 매우 낮음.

- 정확성을 위해 NCMEC에 작성된 모든 보고서는 수동 검토

그렇다 치고, 신뢰할 수 있는 외부 감사는? 애플이 정말 사용자의 디바이스에서 정보를 수집하지 않는다는 것을 증명할 시스템은 있는가? 등 사용자 입장에서 불편한 질문을 던져보면 대부분 답이 없을 것 같습니다. 애플은 콧대가 높으니 적정선까지만 액션을 취해주겠죠. 애플이 유일하게 고개숙이는건 중국 뿐..

우리가 볼 수도 있고 안 볼 수도 있고..

어차피 그들의 시스템이나 소스코드 등이 공개되지도 않는데 우리가 뒤에서 어떻게 굴러가는지 알 수 있는 방법은 없습니다.

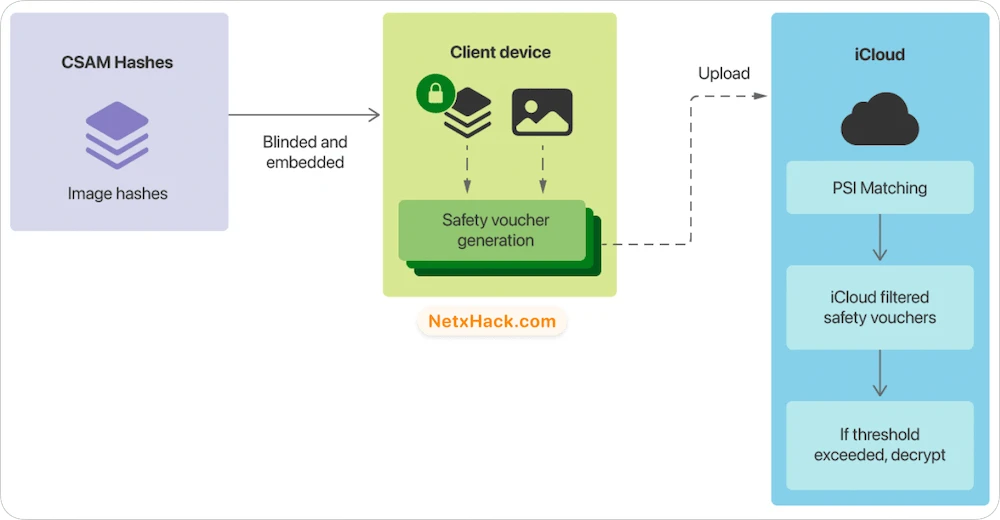

- NCMEC 및 어린이 안전과 관련된 단체들이 제공하는 데이터를 기반으로한 CSAM Image HASH 데이터베이스(DB)가 있음

- DB를 읽을 수 없는 해시 집합으로 변환해 사용자 디바이스에 저장

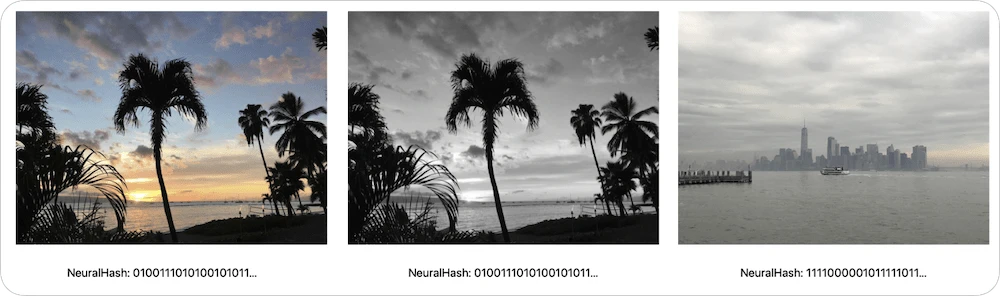

- NeuralHash라고 불리는 기술이 호갱님의 이미지들을 특정 값으로 변환

- CSAM DB가 장치 내에서 일치하는 이미지를 탐색하며, iCloud Photos에 저장되기 전에 매칭 프로세스가 수행됨

- 해당 프로세스는 결과를 공개하지 않고 일치 여부를 결정하는 Private set intersection라는 암호화 기술에 의해 구동

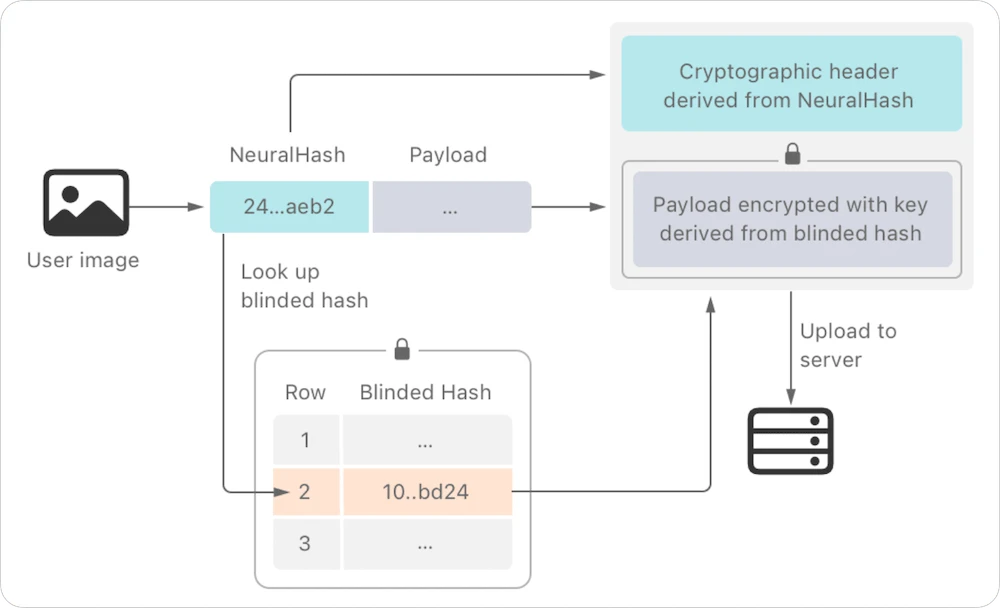

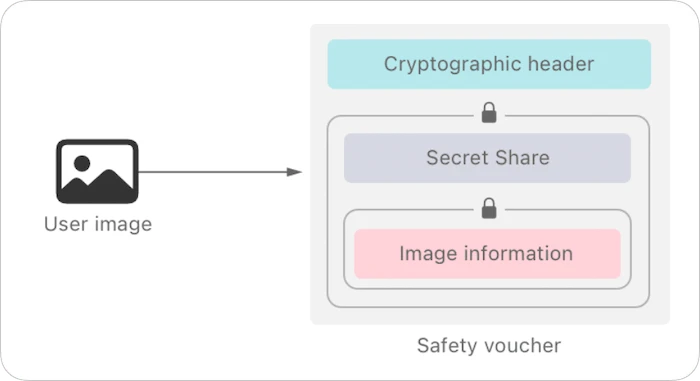

- 장치내에서 일치하는 결과를 인코딩하는 암호화 안전 바우처를 생성

- 바우처는 이미지와 함께 iCloud 사진에 업로드

- Threshold secret sharing(임계값 비밀 공유?)라는 기술을 사용해 iCloud 포토 계정에 올라간 사진이 특정 임계값을 넘지 않는 한 애플에서 안전 바우처의 콘텐츠를 해석할 수 없음.

- 그런데 반대로 값을 넘으면 애플이 콘텐츠 해석 가능하다는 뜻인데 늬들 기술 문제로 잘못 측정된다면, 혹은 기술적 오류인것처럼 해버리면? 국가 기관을 거치겠지만 미 정부가 애플의 관련 소스 코드를 다 검증하는 것도 아닐텐데..? 등등의 상상을 하게 됩니다.

NeuralHash란?

NeuralHash로 우리의 이미지를 해시값으로 바꾼다는데..

Hyperplane LSH (Locality Sensitivity Hashing) 디스크립터를 정수로 변환하고 어쩌고 저쩌고… 이미지를 실수 값 벡터 어쩌고… 블라블라..

그냥 이미지를 애플의 알고리즘을 통해 특정 값으로 바뀌는 겁니다. 많이 간단하게 예를 들면 ‘오징어게임 기훈이형’ = ‘456’ 이렇게; 그런데.. 우리가 이런거 알아서 뭐해요..

기술 설명 : 이래저래 하여튼 님의 이미지는 이거다 싶으면 우리 손으로 ㅋ

안전 바우처(Safety Voucher)는 위의 구조로 생성됩니다.

지난번에 발표했던 계획은 3가지였습니다.

- 이미지 스캔

- 메세지

- 검색 내용 식별

첫번째 두번째는 위에서 설명드렸는데, 어떻게 보면 3번째가 더 소름입니다. 얘들이 아무리 암호화해서 전송하고 어쩌고해도 결국 핵심은 ‘실시간 체킹 그리고 애플로 전송’인데 우리가 하는 행동이 감시당한다는 것인데 검색 내용까지 들여다 볼 수 있다는 것을 상상만해도 구역질 납니다.

실제로 CSAM 키워드 API 제공하는 곳(safer.io)도 있더군요. 구글은 구글 검색 및 유튜브 등에서 CSAM 관련 키워드는 검색하지 못하도록 막고있는데(#구글blog) 구글의 것은 자사 서비스에서 해당 키워드를 사용하지 못하도록 하는 패시브 기능이라 상관없지만, 애플의 의도는 일단 실시간으로 입력하는 것을 체킹하고 거기서 골라낸다는 것이라 차원이 다릅니다.

명분이야 ‘문제 되는 것만’이겠지만 사용자의 검색 행위를 은밀한 방법으로 자신들의 이익을 위해 사용하거나 이 ‘무서운 무기’의 손잡이를 미국 정부가 몰래 잡는다면?

Siri, Spotlight, Safari 검색 시 CSAM 기준에 적용될만한 것을 검색할때 개입하도록 업데이트 되었음.

여기서 생각해볼 문제.

- 앞서 언급했듯 부모의 결정하에 아동을 보호하기 위한 범위면 두손 두발 다 들고 환영이지만 누구나에게 적용된다면..?(특히 하드웨어적 차이가 아닌, 소프트웨어 설정으로 가능한 부분인데 내부의 CCTV가 나를 향하지 않는다는 보장은?)

- 특정 상황에서 개입이 된다면 평소 모든 것을 실시간 필터링하고 있다는 뜻은 아닌가?

- 사용자들의 모든 행동 패턴에 대한 데이터가 그들의 이익을 위해 쓰여진다면?

- 뉴럴해시의 정확도는 얼마나 높은가? 엉뚱한 사진을 리포팅한다면? 작은 기술적 결함을 핑계로 많은 사진을 긁어간가면?

저의 고민이 과할 수 있지만, 바로 우리 옆나라 중국에서는 이미 현실이며, 무한경쟁시대 속에서 기업의 데이터에 대한 욕심은 사그라 들 수 없습니다. 그게 바로 수익이고 경쟁 우위를 점할 수 있는 무기거든요. 페이스북이 그렇게 욕을 먹으면서도 계속 그 욕먹을 짓을 멈추지 못하는 이유 입니다.

현실판 빅브라더가 이런식으로 시작되나 싶어 우려가 됩니다. SNS, 특정 프로그램 등 안쓰면 그만이지만 현대인에게 스마트폰 없는 삶이란 상상할 수 없고 아이폰을 쓰지 않을 수 없는 사람이 전세계게 수억명일텐데..

아 그래서 뭐? – 애플 CSAM 결론

- 우리가 기술적인 부분을 어느정도 이해한다고 해도, 어차피 핵심과 이면적인 부분은 외부인이 알 수 없는 것이고.. 알려진 것으로만 봤을때 결론은 우리의 사생활은 (눈 감은척 하는)애플의 손바닥안에 있거나 언제든 그렇게 될 수 있는 시스템은 갖추어져 있다.

- 아주 간단한 예를 들면 ‘검열 기술+잘못된 정치적 목적=We Chat 및 중국의 AI 기반 감시 시스템‘ 이것만 보더라도 ‘기술’이라는게 언제든 누구든 겨눌 수 있는 칼과 감옥이 될 수 있다는 것.

- 나만의 지나친 착각과 우려일까? No. 전세계 많은 단체와 개인들이 걱정하는데는 이유가 있음.

- 내부 직원(관련글), 애드워드 스노든(트윗), EFF(글읽기) 언론(기사) 보안 전문가(트윗) 등등 전세계의 수 많은 사람들..

- 전 세계의 80개 이상의 민간단체들이 입을 모아 공개 서한을 보내기도 했는데, 핵심적인 부분을 요약하면 아래와 같습니다.

- CSAM 기술은 아동 학대 확산을 줄이기 위한 것이나, 이 백도어 기능이 내장되면 전 세계 사람들의 사생활과 보안을 위협하는데 사용되어 재앙적인 결과를 초래할 수 있다.

- CSAM 뿐 아니라 전 세계 각 정부가 불쾌하다고 판단되는 이미지도 스캔해야한다는 압력 및 법적 요구사항에도 직면하게 될 것(*응 China)

- 나만의 지나친 착각과 우려일까? No. 전세계 많은 단체와 개인들이 걱정하는데는 이유가 있음.

- 그렇지 않아도 중국 시진핑의 말이라면 무릎 꿇고 경청하는 애플이 뜨끈한 백도어를 진핑이형 드나들수 있도록 레드카펫 깔아줄 가능성은 없을까? 하는 생각도 듭니다.

- 애플만 문제인가?

CSAM 근황

- 2022년 : 9월쯤 반발이 심해져 포기한다는 말이 나왔는데 12월 기사를 보니 ‘iCloud 에서는’ CSAM 검사를 하지 않는다고 발표했습니다. (9to5Mac) 일단 클라우드 검사만 빼고 여지를 남겨두었어요.

- 하지만 미성년자가 사진을 전송 및 수신하는 것을 감지하고 경고하는 필터링 기능을 더 강화할 것이라고 이야기 했습니다. 더 나아가 동영상도 필터링 할거라고 하네요.

- iMessage 이외에 다른 앱에서도 ‘온디바이스 머신러닝 기반 CSAM 감지 기능’을 사용하겠다고 하네요. 다만 논란을 조금이라도 피하기 위해서 디폴트는 꺼짐으로 해놓는다고는 하는데 그때 가봐야 아는거고 뒤에 어떻게 바뀔지는 모릅니다. – Wired 기사인데 사이트에서 글 일부만 보이게 바뀌어서 링크는 걸지 않았습니다.

- 2023년 : 일시적일지는 모르겠으나, 중단하는 분위기를 풍기고 있습니다. Wired 기사가 나왔지만 풀버전은 구독자만 볼 수 있으며, 저 기사 자체가 아동 단체와 애플이 주고 받은 편지 내용에 대한 것이라 아래 전문과 함께 요약 글을 올립니다.

포토 스캐닝 기술 포기?

“애플의 CSAM 사진 스캔 도구 중단 결정이 새로운 논란을 불러일으키고 있다.”는 제목의 기사 입니다.

아동 안전 단체인 Heat Initiative는 아동 성학대 자료 스캔 및 사용자 신고에 대해 Apple을 압박하는 캠페인을 시작할 계획이고, 애플은 이례적으로 상세한 답변을 발표했습니다. Apple의 사용자 개인정보 보호 및 아동 안전 책임자인 Erik Neuenschwander의 답변 등에 대한 내용이 꽤 깁니다.

Apple이 Heat Initiative에 보낸 이메일 답변은 민감한 정보를 가리고 PDF 파일로 공개가 되었습니다. – apple-letter-to-heat-initiative

아래는 전체 내용을 다 읽어볼 필요 없는 사람들을 위해 번역기 돌린 내용에서 안 읽어도 되는 부분 잘라내고, 최대한 짧게 요약한 것 입니다.

Tim에게 Apple이 CSAM 검열을 결정했을때 기뻤는데, 이 계획을 멈추고 2022년 12월에 조용히 취소한 것은 너무 실망스러워. 계획을 지연시키지 말고 원래 우리가 이야기 했던거 해줘. - iCloud에서 아동 성 학대 이미지 및 동영상을 감지, 신고 및 삭제. - 사용자가 아동 성 학대 이미지와 동영상을 Apple에 신고할 수 있는 강력한 신고 메커니즘 구축. 일주일 뒤에 언론에 공개할거야 사라 가드너 히트 이니셔티브 CEO

Apple의 답신 (2023년 8월 31일) 그래, 옳은 일이야. 우린 노력했고 앞으로도 노력할거야. 어린이들의 안전을 위해 Apple은 지금까지 이것.. 저것.. 엄청 많이 해왔어. 우리가 이런 일들을 했잖아. - 커뮤니케이션 세이프티 기능은 애들이 보내면 안되는 사진이나 메세지 보내려고 할 때 개입할 수 있도록 설계했고, 모든 자녀 계정에는 이 기능이 기본으로 켜져있게 했어. - 이미지 뿐 아니라 동영상 콘텐츠에도 적용시켰으며 에어드랍, Photo picker, 페이스타임 메세지, 연락처 포스터 등 전반적으로 보호 기능을 확대 적용. - 이런 종류의 기술에 투자했고 앞으로도 그럴 계획. 그런데 iCloud 사진의 CSAM 스캐닝을 위한 하이브리드 클라이언트 - 서버 접근 방식에 대한 제안을 진행하지 않기로 했는데 그 이유가 있어. - 전문가와 각 단체들과 협의하고 검토해보니까 사용자의 보안과 개인정보 보호를 위협하지 않고서는 기술 구현이 불가능해 - iCloud에 업로드 된 사용자의 비공개 데이터를 스캔하는 것은 여러가지 보안 위협 가능성이 생길 수 있고 대량 감시의 문이 열릴 수 있어. 좋은 일인거 알거든? 앞으로 계속 논의는 해보자 에릭 노이엔슈반더, 사용자 개인정보 보호 및 아동 안전 담당 이사

같이 읽으면 재미있는 글

- 애플의 대표적인 프라이버시 기능 중 하나인 비공개 릴레이

- 파이브 아이즈에 대해서 나름 상세하게 써놨습니다.

- VPN과 Tor중 뭘 써야 할까요? 둘 중 뭐가 더 좋냐고 물어보시는 댓글이 있어서 글을 따로 작성해서 비교했습니다. – VPN vs Tor

- FBI, CIA, NSA는 VPN 암호화 해독 가능할까?

애플 계정으로 아이폰이나 아이패드에 로그인 되어 있다고 해서 폰이나 태블릿에 있는 인터넷 방문 기록이나 통화내역… 문자나 사진 같은 것들을 들여다 볼 수 있는건 아니겠죠? 구글 버리고 애플로 넘어가려고 했는데 이런걸 보니 무섭네요 ㄷㄷ

그런것까지 들여다봤다가는 아마 난리날거예요. 그정도까진 걱정하지 않으셔도 됩니다. 다만 중국에서는 좀 다르구요

나무위키에 스캠 관련 문서에 내용을 개제하니 삭제하는 세력이 존재했습니다 참고하세요

익명님께서 CSAM 관련 문서에 이 글을 링크했더니 삭제됐다는 말씀인가보군요. 그래도 제 글을 좋게 봐주시는 분이 계셔서 감사할 따름입니다! 🙂

마지막 편지 요약 재미있게 잘봤어요 ㅋㅋ 애플 검열은 일단.. 한동안은 그리 걱정하지 않아도되겠군요… 고양이랑 음식 사진이 거의 대부분이지만 뒤에서 내가 모르는 일이 벌어지는거같아서 찜찜했는데 검색하다 글보고 맘놓게됐네요

재미있게 읽어주셔서 감사합니다. 🙂

이게 일반인도 모두 저렇게 감청을 할수 있다는건가요? 아님 특정 기능을 활성화 한사람만이 저렇게 된다는건가요?

AI를 통해 자동으로, 그리고 탐지된 데이터는 사람이 확인합니다. 모두에게 적용됩니다.

아이폰 골수 유저인데 너무 재미있게 읽고갑니다 아이폰도 감청 검열이 될까? 궁금한 마음에 검색하다 들어왔는데 제일 상세하게 설명해주신거같아요

칭찬 감사합니다. 나름 열심히 썼는데 힘이 납니다.

지금까지 CSAM 관련 글 본거중에 제일 호기심해결이 많이됐어요 나무위키도 내용이 별로없던데. 감사용

부족한게 많습니다. ㅎㅎ 칭찬 감사합니다.